CVPR (IEEE/CVF Conference on Computer Vision and Pattern Recognition)是计算机视觉领域全球最有影响力的会议,受到全世界学界和工业界的广泛关注。本届CVPR共有来自76个国家和地区的超过12000人参加了线下会议,是CVPR历史上与会人数最多、规模最大的一届。今年CVPR共收到11532篇论文投稿,相比2023年的9155篇增加了25%,论文数量达到了历史新高,录取率却从去年的25.8%小幅下降到了23.6%, 仅2719篇被接收,竞争愈发激烈。而银杏智教平台三名博士生论文录取,并赴西雅图参加国际人工智能顶级会议CVPR 2024。

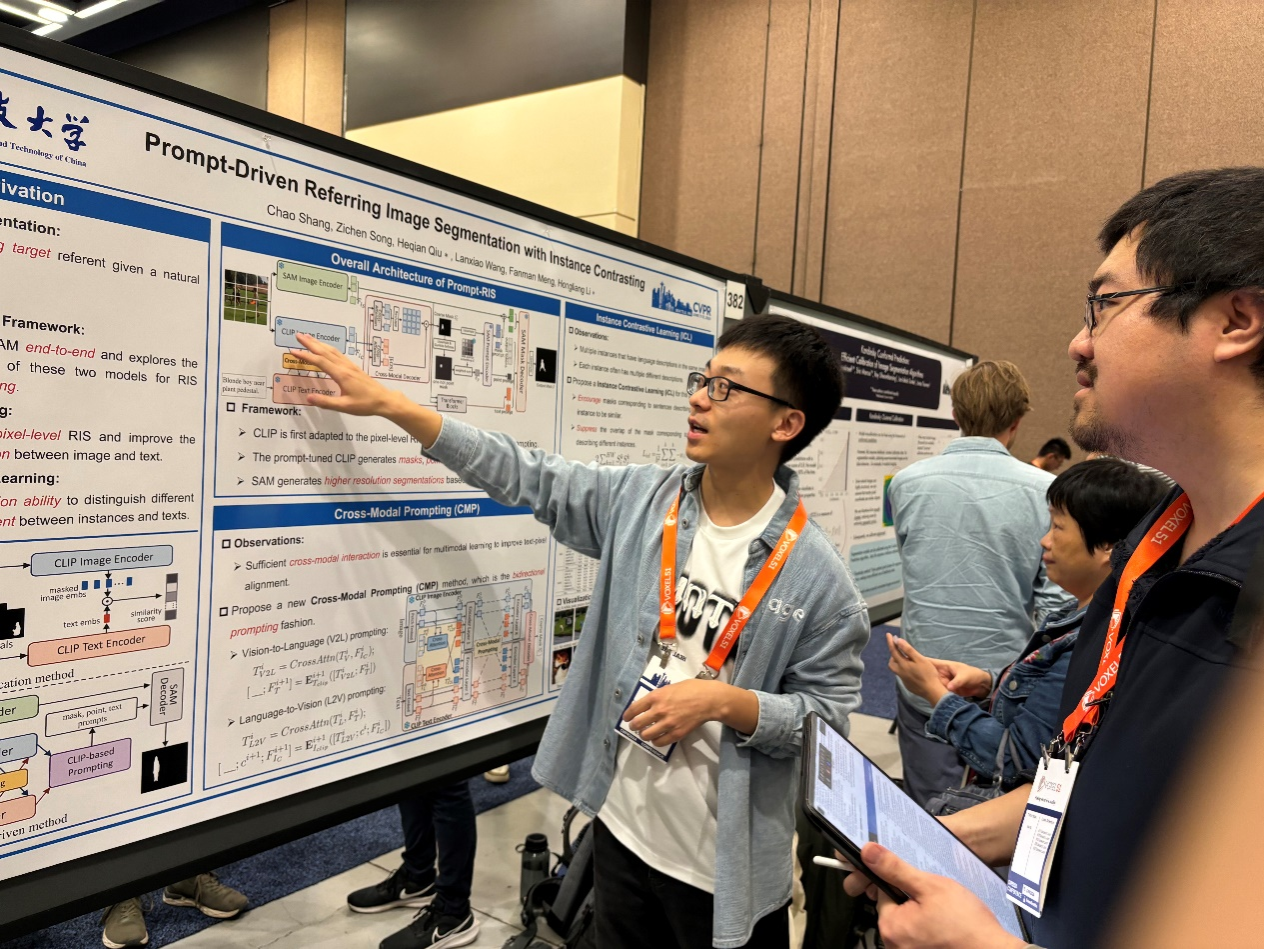

项目成员博士生尚超为第一作者,李宏亮教授和邱荷茜博士为通讯作者共同完成的研究论文《Prompt-Driven Referring Image Segmentation with Instance Contrasting》被人工智能顶级会议CVPR 2024接收。多模态目标分割任务的目的是理解文本表达的语义,在图像中对文本描述的目标进行像素级分割。随着在大规模数据集上预训练的模型的兴起,强大的泛化能力让大模型在多种下游任务中获得了显著的性能提升。如何将大模型应用于多模态分割任务,并充分挖掘大模型丰富的知识以及强大的泛化能力,成为了当前多模态分割任务中极具挑战性的难点。为了解决上述问题,该论文提出了一种新颖的基于提示学习的多模态目标分割框架,称为Prompt-RIS。该网络框架将现有的多模态大模型CLIP和图像分割大模型SAM端到端地结合起来,并通过提示学习将CLIP和SAM在大规模数据集上学习到的丰富的知识迁移到多模态目标分割任务中。基于该框架,该论文提出了跨模态的提示学习方法,将图像级的CLIP模型应用于像素级的分割任务中并提升跨模态的信息交互。此外,该论文提出了实例对比学习方法,提高模型对不同实例的区分能力,以及对描述同一实例的不同文本的鲁棒性。

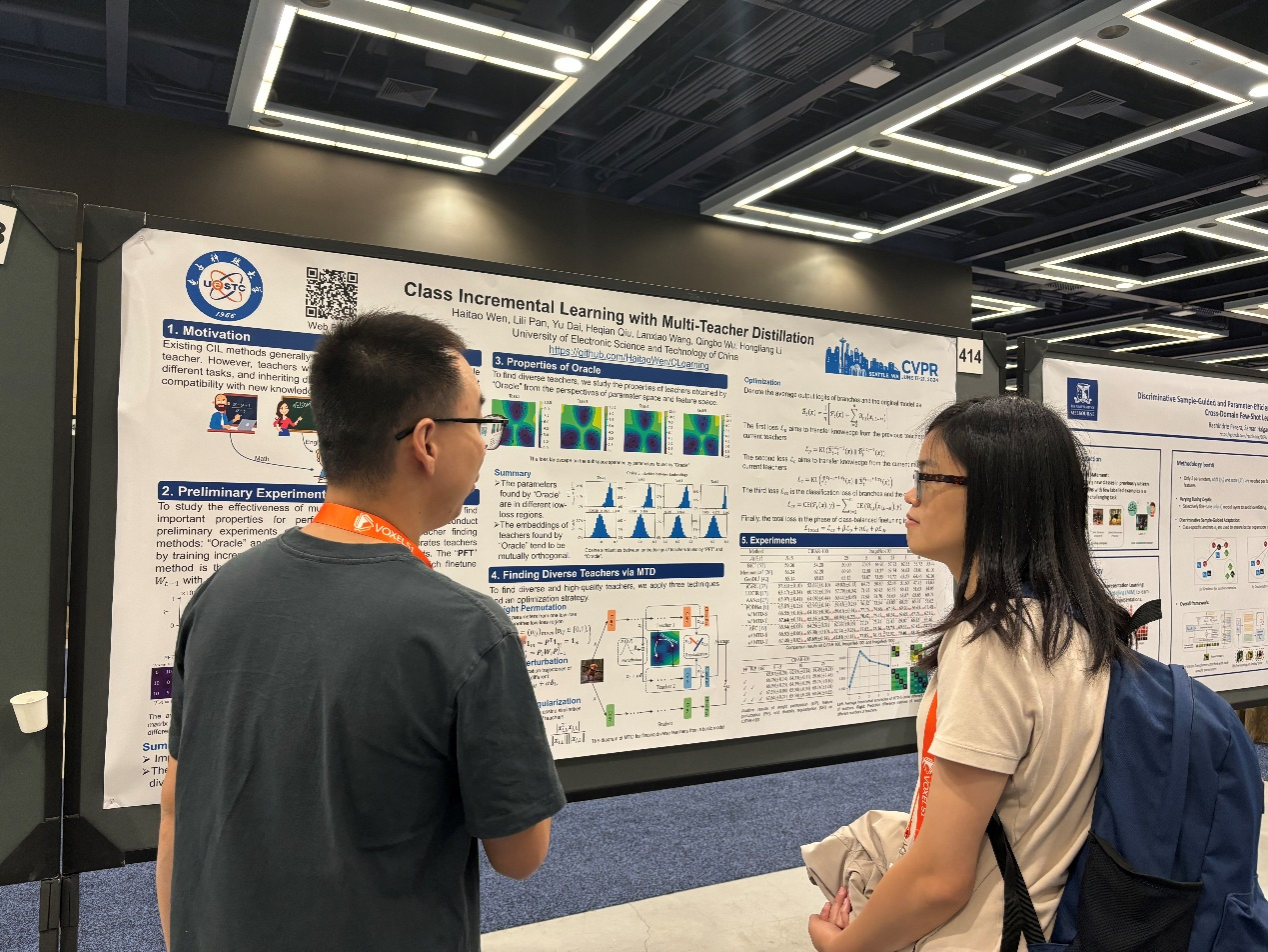

项目成员博士生问海涛为第一作者,李宏亮教授为通讯作者共同完成的研究论文《Class Incremental Learning with Multi-Teacher Distillation》被人工智能顶级会议CVPR 2024接收。知识蒸馏是类增量学习中缓解灾难性遗忘的主要方法。现有方法通常从单个教师模型中继承知识。然而,具有不同预测机制的教师擅长不同的任务,从中继承多样的知识能够增强对新知识的兼容能力。为此,该论文提出MTD方法为增量学习寻找多样的教师。具体地,该文基于Oracle教师的两个关键特性:1.多样教师的参数处于不同的低损失区域;2.多样教师的特征倾向于相互正交,采用3个技术模仿多样教师的特性:1.权重排列,重新排列模型中的神经元将基本模型的参数从一个低损失区域传输到另外一个低损失区域;2.特征摄动,向不同分支的输入加入扰动使不同分支具有不同的优化轨迹;3.多样性正则,最小化分支间绝对余弦相似度。为减少时间与存储上的消耗,每个教师被表达为模型中的一个小分支。

项目成员博士生邱子欢为第一作者,孟凡满教授为通讯作者共同完成的研究论文《Dual-consistency Model Inversion for Non-exemplar Class Incremental Learning》被人工智能顶级会议CVPR 2024接收。深度模型的增量学习能力至关重要。传统类增量学习要求保存部分旧类别样本,导致数据隐私,版权以及存储等问题。无模范的类增量学习无需进行回放学习,但更加容易发生灾难性遗忘。目前无模范类增量学习主要采用知识蒸馏巩固旧类表示,使用新类别样本或反演样本作为蒸馏数据。然而,前者与旧类分布具有语义差异,后者在领域分布上与真实样本缺乏一致。为生成更有效的蒸馏数据,本文提出双一致性模型反演方法DCMI,使生成数据在语义和领域分布上与真实旧类分布更加一致。实验表明,DCMI在无模范类增量学习基准下取得了最先进的性能。