会议:CVPR 2024

作者:问海涛;潘力立;戴禹;邱荷茜;王岚晓;吴庆波;李宏亮

论文简介:

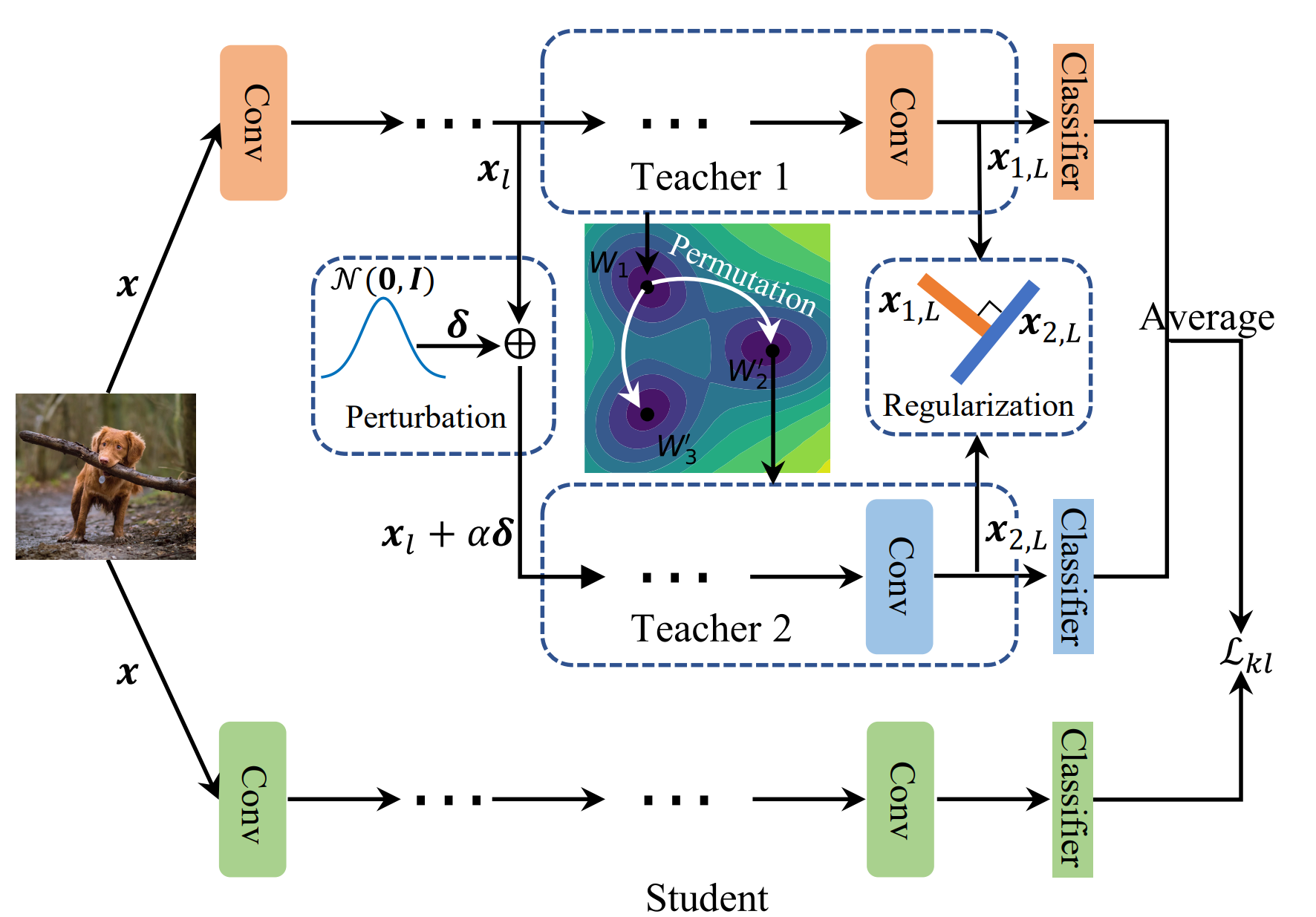

知识蒸馏是类增量学习中缓解灾难性遗忘的主要方法。现有方法通常从单个教师模型中继承知识。然而,具有不同预测机制的教师擅长不同的任务,从中继承多样的知识能够增强对新知识的兼容能力。为此,该论文提出MTD方法为增量学习寻找多样的教师。具体地,该文基于Oracle教师的两个关键特性:1.多样教师的参数处于不同的低损失区域;2.多样教师的特征倾向于相互正交,采用3个技术模仿多样教师的特性:1.权重排列,重新排列模型中的神经元将基本模型的参数从一个低损失区域传输到另外一个低损失区域;2.特征摄动,向不同分支的输入加入扰动使不同分支具有不同的优化轨迹;3.多样性正则,最小化分支间绝对余弦相似度。为减少时间与存储上的消耗,每个教师被表达为模型中的一个小分支。