会议:CVPR 2023

作者:尚超;李宏亮;孟凡满;吴庆波;邱荷茜;王岚晓

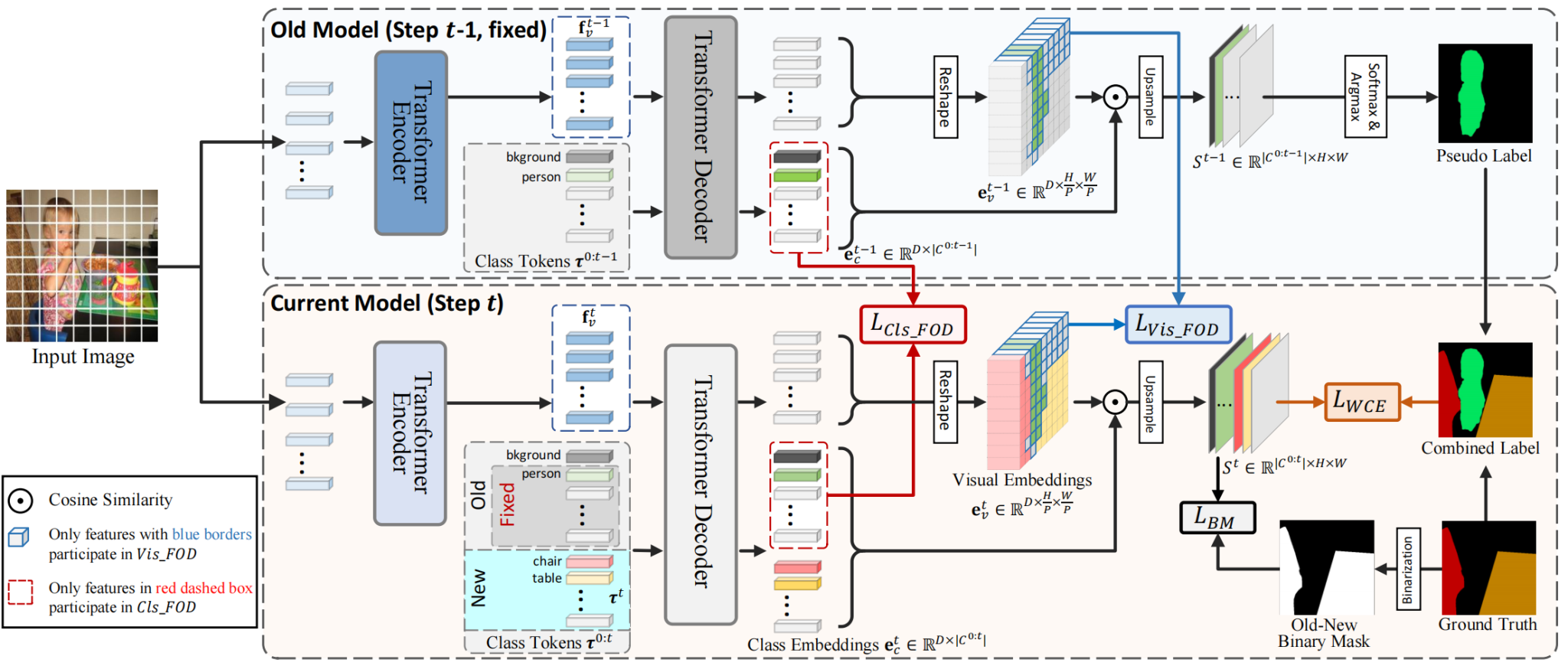

论文简介:类增量式语义分割旨在增量地学习新类,同时保持对旧类的分割能力,并且由于旧类标签不可用而遭受灾难性的遗忘。现有的方法大多是基于卷积网络,通过知识蒸馏来防止遗忘,这需要增加额外的卷积层来预测新类,(2)在知识蒸馏过程中忽略了区分新旧类对应的不同区域,粗略地提取了所有特征,从而限制了新类的学习。基于上述观察,该论文提出了一种新的类增量语义分割的转换器框架,称为Incrementer,它只需要向转换器解码器添加新的类令牌即可进行新类学习。在incrementor的基础上,提出了一种新的知识蒸馏方案,以老类区域的知识蒸馏为重点,减少了旧模型对新类学习的约束,提高了模型的可塑性。此外,该论文提出了一种类反融合策略,以减轻对新类的过拟合和相似类的混淆。该论文的方法简单有效,大量的实验表明,该论文的方法在很大程度上优于sota (Pascal VOC和ADE20k都提高了5 - 15个绝对分数)。该论文希望该论文的Incrementer可以作为一个新的强大的管道类增量语义分割。