期刊:IEEE Transactions on Multimedia, 2024.

作者:许林峰;吴庆波;潘力立;孟凡满;李宏亮;贺驰原;王涵昕;程少旭;戴禹

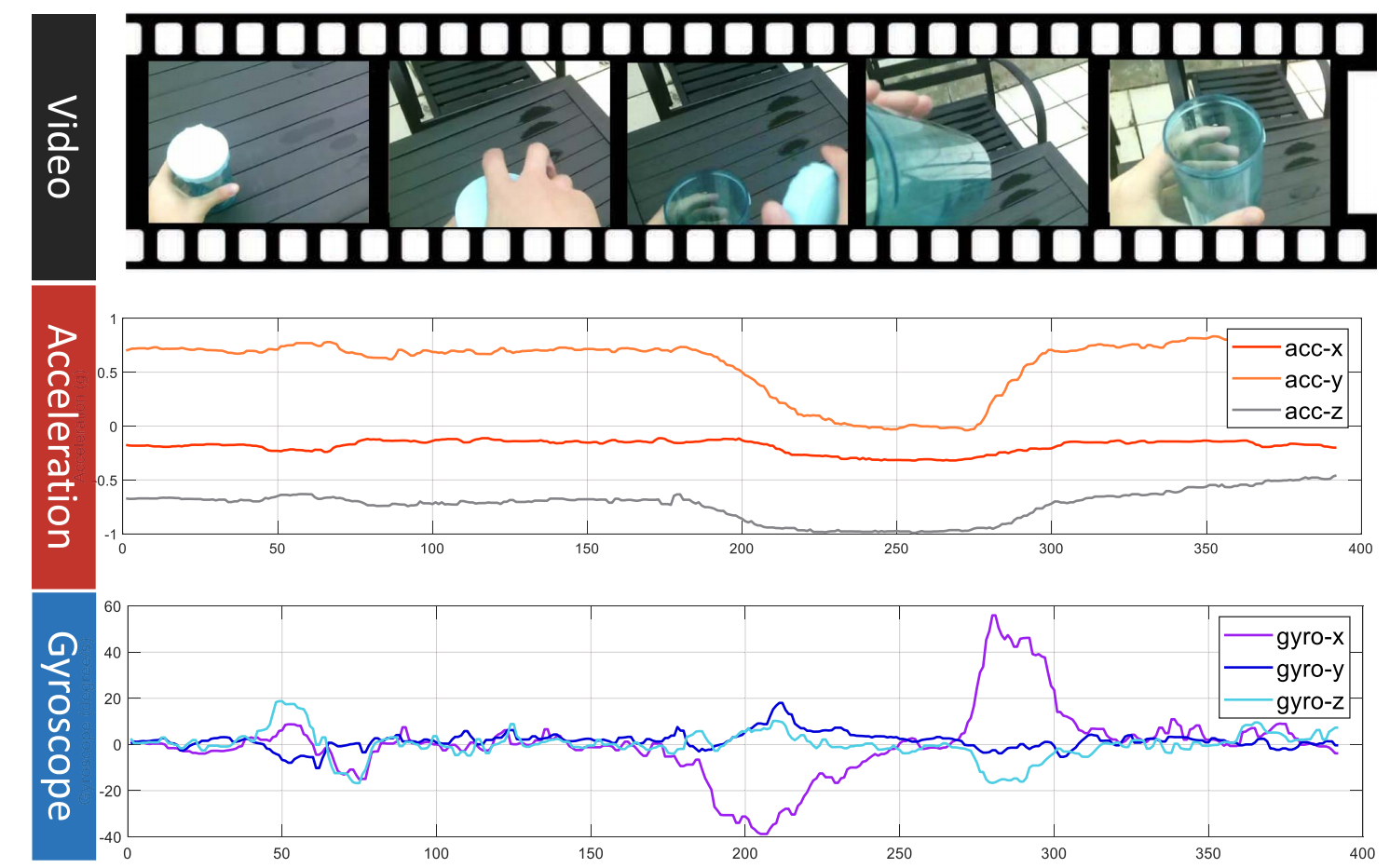

论文简介:随着可穿戴相机的快速发展,现在可以大幅度增加第一人称视角视频的收集量,以用于第一人称视觉感知。然而,这一发展受到多模态第一人称视角活动数据集短缺的阻碍。此外,作为持续学习的一个分支,多模态持续活动学习的灾难性遗忘问题尚未得到充分研究,这使得积累更多多模态活动数据变得更加迫切。为了解决这一短缺问题,本文提出了一个名为UESTC-MMEA-CL的多模态第一人称视角活动数据集,用于持续活动学习。该数据集是使用该论文自主研发的带有第一人称相机和可穿戴传感器的眼镜收集的,包含10名佩戴该论文眼镜的参与者执行的32种日常活动的视频、加速度计和陀螺仪的同步数据。该论文提供了传感器数据的统计分析,以展示其在活动识别中的辅助作用。该论文报告了在基础网络架构上分别和联合使用三种模态(RGB、加速度和陀螺仪)进行第一人称视角活动识别的结果。该论文全面评估了四种具有不同多模态组合的基线方法,以探索在UESTC-MMEA-CL上进行持续学习时的灾难性遗忘问题。该论文希望UESTC-MMEA-CL数据集能够成为未来可穿戴应用中第一人称活动识别持续学习研究的促进剂。